Kolejną nową i darmową wtyczką, która pojawiła się w sieci jest Dexed – pobieramy ją z tej lokalizacji (szukać pod Binary downloads). Jest ona w jeszcze dość wczesnej fazie rozwojowej, ale zapowiada się interesująco. Przede wszystkim jest to wtyczka dla PC, Mac i Linuks, a to już duży plus. Poza tym jest dość wierną emulacją legendarnej Yamahy DX7, którą usłyszymy w większości nagrań z lat 80., zwłaszcza z kręgu tzw. muzyki new romantic. Problem z DX7 był taki, że muzycy nie bardzo wiedzieli jak ją programować, bo synteza FM bazująca na operatorach, w której filtr miał znaczenie drugorzędne, a często go w ogóle nie stosowano, była – i często jest dla wielu – nie do ogarnięcia. Z tego też względu wszyscy grali presetami i te same dźwięki można było usłyszeć w dziesiątkach piosenek. W zasadzie DX7 uformowała pewną stylistykę brzmieniową, którą obecnie utożsamiamy z pewnym okresem w historii muzyki. Co by jednak o tym syntezatorze nie mówić, jego możliwości w zakresie kreacji barw są praktycznie nieograniczone, i Dexed może nam pomóc w rozszyfrowaniu wielu zależności. Szczególnie ładnie brzmią tu wszelkiego typu dzwonki i łagodne pady. Te brzmienia mają w sobie coś magicznego, jakąś nostalgię i własny charakter (na pewno usłyszycie tam szereg barw znanych z płyt Yazoo). Dlatego właśnie warto ten syntezator wypróbować. Dla tych, którzy się wahają, czy pobierać, czy nie, poniżej krótki przegląd presetów, który w pewnym zakresie pokazuje możliwości instrumentu. Pod koniec prezentacji można usłyszeć jakie zmiany do brzmienia wprowadza rekonfiguracja operatorów. Zachęcam do bliższego przyjrzenia się temu instrumentowi, bo moim zdaniem synteza FM jest najmniej docenianą formą kreowania dźwięków, choć pod wieloma względami bije na głowę możliwości syntezatorów subtraktywnych.

Kolejną nową i darmową wtyczką, która pojawiła się w sieci jest Dexed – pobieramy ją z tej lokalizacji (szukać pod Binary downloads). Jest ona w jeszcze dość wczesnej fazie rozwojowej, ale zapowiada się interesująco. Przede wszystkim jest to wtyczka dla PC, Mac i Linuks, a to już duży plus. Poza tym jest dość wierną emulacją legendarnej Yamahy DX7, którą usłyszymy w większości nagrań z lat 80., zwłaszcza z kręgu tzw. muzyki new romantic. Problem z DX7 był taki, że muzycy nie bardzo wiedzieli jak ją programować, bo synteza FM bazująca na operatorach, w której filtr miał znaczenie drugorzędne, a często go w ogóle nie stosowano, była – i często jest dla wielu – nie do ogarnięcia. Z tego też względu wszyscy grali presetami i te same dźwięki można było usłyszeć w dziesiątkach piosenek. W zasadzie DX7 uformowała pewną stylistykę brzmieniową, którą obecnie utożsamiamy z pewnym okresem w historii muzyki. Co by jednak o tym syntezatorze nie mówić, jego możliwości w zakresie kreacji barw są praktycznie nieograniczone, i Dexed może nam pomóc w rozszyfrowaniu wielu zależności. Szczególnie ładnie brzmią tu wszelkiego typu dzwonki i łagodne pady. Te brzmienia mają w sobie coś magicznego, jakąś nostalgię i własny charakter (na pewno usłyszycie tam szereg barw znanych z płyt Yazoo). Dlatego właśnie warto ten syntezator wypróbować. Dla tych, którzy się wahają, czy pobierać, czy nie, poniżej krótki przegląd presetów, który w pewnym zakresie pokazuje możliwości instrumentu. Pod koniec prezentacji można usłyszeć jakie zmiany do brzmienia wprowadza rekonfiguracja operatorów. Zachęcam do bliższego przyjrzenia się temu instrumentowi, bo moim zdaniem synteza FM jest najmniej docenianą formą kreowania dźwięków, choć pod wieloma względami bije na głowę możliwości syntezatorów subtraktywnych.

Podsumowując: wtyczka powstała na frameworku JUCE na bazie silnika music-synthesizer-for-android, działa na platformach OS X, Windows i Linux jako VST/AU w wersji 32 i 64 bity, ma brzmienie bardzo zbliżone do oryginalnej DX7, 144 w pełni automatyzowane parametry, obsługuje SysEx dla DX7 (i pozwala ładować brzmienia tego instrumentu, których w sieci znajdziecie mnóstwo), a każdy oparator ma wskaźnik poziomu, co pozwala szybko zorientować się który z nich gra

tutoriale

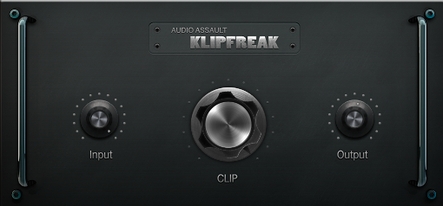

Bezpłatny KlipFreak dla PC i Mac (wideo)

Audio Assault KlipFreak to ciekawa, bezpłatna wtyczka klipera, której zadaniem jest obcinanie wierzchołków sygnału w możliwie najbardziej muzyczny sposób. Interesującą cechą tego procesora jest to, że dostępny jest zarówno dla komputerów PC jak i Mac, w wersji 32- i 64-bitowej oraz formatach VST, AU i RTAS. Poniżej prezentacja zastosowania tej wtyczki w obróbce pętli perkusyjnej. Wtyczkę można pobrać ze strony producenta. Jak deklarują twórcy, KlipFreak przeznaczony jest głównie do obróbki pętli perkusyjnych oraz pracy na grupie lub sumie, choć możliwości tego narzędzia są oczywiście znacznie większe. Należy jednocześnie pamiętać o tym, że sygnały o niskiej częstotliwości mają większą energię niż tony średnie i wysokie, więc to one będą pierwsze podlegały obcinaniu, co może wywołać mało przyjemny efekt brzęczącego dźwięku w zakresie harmonicznych sygnału stopy. Jak jednak pokazano niżej, można to sprytnie ominąć, a przy okazji „wycisnąć” z pętli więcej dynamiki. Wtyczka ma własny moduł limitera, który ogranicza poziom sygnału wyjściowego.

Audio Assault KlipFreak to ciekawa, bezpłatna wtyczka klipera, której zadaniem jest obcinanie wierzchołków sygnału w możliwie najbardziej muzyczny sposób. Interesującą cechą tego procesora jest to, że dostępny jest zarówno dla komputerów PC jak i Mac, w wersji 32- i 64-bitowej oraz formatach VST, AU i RTAS. Poniżej prezentacja zastosowania tej wtyczki w obróbce pętli perkusyjnej. Wtyczkę można pobrać ze strony producenta. Jak deklarują twórcy, KlipFreak przeznaczony jest głównie do obróbki pętli perkusyjnych oraz pracy na grupie lub sumie, choć możliwości tego narzędzia są oczywiście znacznie większe. Należy jednocześnie pamiętać o tym, że sygnały o niskiej częstotliwości mają większą energię niż tony średnie i wysokie, więc to one będą pierwsze podlegały obcinaniu, co może wywołać mało przyjemny efekt brzęczącego dźwięku w zakresie harmonicznych sygnału stopy. Jak jednak pokazano niżej, można to sprytnie ominąć, a przy okazji „wycisnąć” z pętli więcej dynamiki. Wtyczka ma własny moduł limitera, który ogranicza poziom sygnału wyjściowego.

Reaper: różne efekty dla klipów na jednej ścieżce

Zachęcony pytaniem, które pojawiło się na Forum EiS, dotyczącym stosowania różnych efektów w odniesieniu do klipów na jednej ścieżce w programie Reaper, przygotowałem małą lekcję wyjaśniającą ten temat.

Szereg różnych programów DAW oferuje funkcję aplikowania oddzielnych efektów dla pojedynczych klipów znajdujących się na jednej ścieżce (oprócz globalnego efektu dla całej ścieżki). W przypadku Reapera także można skorzystać z tej funkcjonalności, choć trzeba to zrobić trochę „dookoła”. Jednocześnie jednak, Reaper daje interesujące możliwości w zakresie doboru efektów, porównywania różnych wersji z różnymi efektami, co sprzyja kreatywnemu wykorzystaniu tego programu, np. do obróbki pętli czy zaawansowanego przetwarzania kompleksowych nagrań. Poniżej prezentacja tego typu działań. Pokazałem tu wykorzystanie funkcji ujęć (Takes), używając tylko dwóch, ale warto pamiętać, że takich ujęć może być znacznie więcej, każde z innym efektem, co pozwala na dużo bardziej zaawansowane wykorzystanie tej opcji programu.

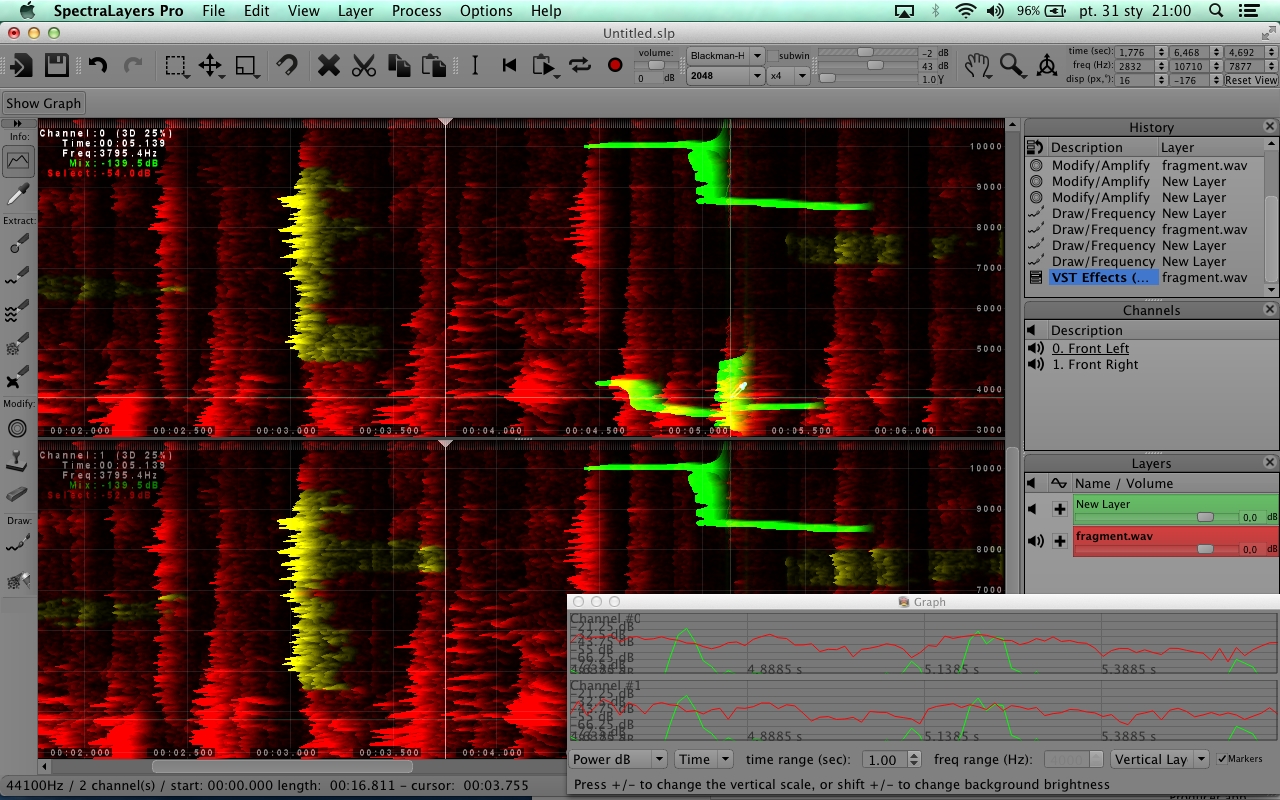

Bezpłatne kursy SpectraLayers

Edycja spektralna materiału audio nie jest zagadnieniem nowym, i kilka firm dość intensywnie zaczęło penetrować ten obszar oprogramowania (iZotope, Adobe, UI Software, Photosounder, Diamond Cut, a nawet Roland). Na ten moment jednak wydaje się, że najbardziej wszechstronnym i funkcjonalnym narzędziem do edycji spektralnej jest Sony SpectraLayers, aktualnie dostępny w wersji 2.1, którą dosłownie przed chwilą otrzymałem do testów, razem z najnowszym Sound Forge Pro Mac 2.0. SpectraLayers 2.1 różni się od wersji 2.0 kilkoma ciekawymi funkcjami, w tym narzędziem do redukcji/eliminacji pogłosu, poprawionym algorytmem redukcji szumów oraz opcją wysyłki odszumionego sygnału na oddzielną warstwę. Trzeba bowiem wiedzieć, że SpectraLayers pracuje na podobnej zasadzie jak Photoshop przy obróbce grafiki bitmapowej – możemy tworzyć różne warstwy, na każdej z nich edytować spektrum sygnału (także z użyciem wtyczek VST), a następnie zgrać całość do postaci pliku audio. SpectraLayers Pro 2.1 doskonale współpracuje z Sound Forge, teraz także z Sound Forge Pro Mac. A jak to wygląda w praktyce, przekonam się za kilka dni, gdy popracuję trochę z nowymi aplikacjami.

Edycja spektralna materiału audio nie jest zagadnieniem nowym, i kilka firm dość intensywnie zaczęło penetrować ten obszar oprogramowania (iZotope, Adobe, UI Software, Photosounder, Diamond Cut, a nawet Roland). Na ten moment jednak wydaje się, że najbardziej wszechstronnym i funkcjonalnym narzędziem do edycji spektralnej jest Sony SpectraLayers, aktualnie dostępny w wersji 2.1, którą dosłownie przed chwilą otrzymałem do testów, razem z najnowszym Sound Forge Pro Mac 2.0. SpectraLayers 2.1 różni się od wersji 2.0 kilkoma ciekawymi funkcjami, w tym narzędziem do redukcji/eliminacji pogłosu, poprawionym algorytmem redukcji szumów oraz opcją wysyłki odszumionego sygnału na oddzielną warstwę. Trzeba bowiem wiedzieć, że SpectraLayers pracuje na podobnej zasadzie jak Photoshop przy obróbce grafiki bitmapowej – możemy tworzyć różne warstwy, na każdej z nich edytować spektrum sygnału (także z użyciem wtyczek VST), a następnie zgrać całość do postaci pliku audio. SpectraLayers Pro 2.1 doskonale współpracuje z Sound Forge, teraz także z Sound Forge Pro Mac. A jak to wygląda w praktyce, przekonam się za kilka dni, gdy popracuję trochę z nowymi aplikacjami.

SpectraLayers otrzymał na właśnie zakończonych targach NAMM nagrodę Editor Choice od redakcji miesięcznika Sound on Sound. Z tej radości firma Sony postanowiła udostępnić zupełnie bezpłatnie komplet materiałów edukacyjnych w formie wideo (łącznie z rejestracjami webinariów), związanych z obsługą tego niesamowitego programu. Gorąco zachęcam wszystkich zainteresowanych tą tematyką do zapoznania się z zawartością tej strony. Można tam znaleźć mnóstwo interesujących informacji i porad na temat SpectraLayers i praktycznego zastosowania tej aplikacji.

Dodam tylko, że autorem SpectraLayers (początkowo Spectral Layers) jest mieszkający we Francji Robin Lobel (rocznik 1984), założyciel firmy Divide Frame, programista związany z rynkiem gier i produkcji filmowych. Stworzony przez niego SpectraLayers znalazł już zastosowanie w takich obrazach jak Men In Black 3, Total Recall, Twilight oraz The Hobbit. Program jest też wykorzystywany przez FBI. Ale to tajemnica…

Nowy system kalibracji i moja (subiektywna) opinia

Szerzy się wśród producentów sprzętu i oprogramowania tendencja do tworzenia nowych, rewolucyjnych systemów kalibracji monitorów w pomieszczeniu odsłuchowym, a przykłady tego typu narzędzi znajdziemy nawet wśród firm z tzw. pierwszej ligi. Na NAMM właśnie pojawił się kolejny taki system stworzony przez łotewską firmę Sonarworks. Idea tego typu systemów jest stosunkowo prosta. W różnych punktach pomieszczenia mierzony jest sygnał wytwarzany przez monitory, a wyniki pomiarów porównywane są z sygnałem wzorcowym. Po porównaniu aplikowane są do sygnału filtry, których zadaniem jest stłumić to, co się za mocno wybija i podbić to, czego jest za mało. Pomiar dokonywany jest w kilku miejscach, aby w ten sposób w pewnym zakresie skompensować różne poziomy poszczególnych fal w różnych miejscach pomieszczenia. I po zaaplikowaniu takiej korekcji już możemy się cieszyć dźwiękiem jak w najlepszych studiach masteringowych. Proste, prawda?

Szerzy się wśród producentów sprzętu i oprogramowania tendencja do tworzenia nowych, rewolucyjnych systemów kalibracji monitorów w pomieszczeniu odsłuchowym, a przykłady tego typu narzędzi znajdziemy nawet wśród firm z tzw. pierwszej ligi. Na NAMM właśnie pojawił się kolejny taki system stworzony przez łotewską firmę Sonarworks. Idea tego typu systemów jest stosunkowo prosta. W różnych punktach pomieszczenia mierzony jest sygnał wytwarzany przez monitory, a wyniki pomiarów porównywane są z sygnałem wzorcowym. Po porównaniu aplikowane są do sygnału filtry, których zadaniem jest stłumić to, co się za mocno wybija i podbić to, czego jest za mało. Pomiar dokonywany jest w kilku miejscach, aby w ten sposób w pewnym zakresie skompensować różne poziomy poszczególnych fal w różnych miejscach pomieszczenia. I po zaaplikowaniu takiej korekcji już możemy się cieszyć dźwiękiem jak w najlepszych studiach masteringowych. Proste, prawda?

Otóż ani trochę. Żaden znany mi system tego typu nie działa w sposób taki, by można było na nim w stu procentach polegać. Owszem, tu i ówdzie pozwala skorygować pewne problemy z odsłuchem, ale jest to proteza, a do tego wyciosana siekierą z kawałka drewna.

Chodzi o to, że zmiany w odsłuchu sygnału w pomieszczeniu, które nie jest dobrze opracowane akustycznie nie odbywają się w domenie częstotliwościowej ale fazowej (czasowej). Powodują je odbicia, które się pojawiają w pomieszczeniu, i na skutek interakcji z sygnałem bezpośrednim są przyczyną kumulowania się bądź odejmowania ciśnień w określonych miejscach pomieszczenia, co skutkuje zmianami w charakterystyce częstotliwościowej. A wyrównywanie tej charakterystyki po stronie źródła to trochę tak, jak leczenie kataru chusteczką do nosa. Źródłowy sygnał o „kłopotliwych” częstotliwościach będzie odpowiednio cichszy i głośniejszy, to prawda, dając subiektywne wrażenie, że ogólna charakterystyka została wyrównana. Ale problem pozostał, ponieważ pomieszczenie się nie zmieniło. W dalszym ciągu będą występować kumulacje i spadki ciśnień w różnych miejscach, tyle tylko, że ich słyszalność jest mniejsza. Pozostają jednak problemy związane ze zmianami fazy. Co więcej, są one pogłębiane przez filtry (dla nadania powagi sprawie zazwyczaj są to filtry z tzw. liniową fazą, czyli nie wprowadzające opóźnień). A tego typu filtry i do tego działające bardzo wąsko i bardzo głęboko, to jedna z najgorszych rzeczy, jaką można do tego typu zadań użyć.

Ale najpierw rzućcie okiem na poniższy filmik. Pokazuję tu zastosowania wąsko działającej filtracji z bardzo dobrego korektora Fab Filter w trybie podbicia i tłumienia w przypadku tzw. zwykłego filtru (zero latency) oraz filtru z liniową fazą. Zwróćcie uwagę co się dzieje z rezonansem.

Jak łatwo można usłyszeć, działaniu ostro strojonych filtrów pasmowych towarzyszy rezonans, czyli wybrzmiewanie częstotliwości jeszcze po zakończeniu trwania sygnału właściwego. Rzecz poniekąd naturalna, bo każdy rezonans to kumulacja energii, która potrzebuje trochę czasu na to, aby się wytracić. O ile jednak w przypadku zwykłych filtrów działających z przesunięciem fazy (opcja zero latency) ów rezonans pojawia się PO zakończeniu dźwięku właściwego, o tyle w przypadku filtrów z liniową fazą (ponieważ działają one z opóźnieniem potrzebnym na przetworzenie sygnału) rezonans ten pojawia się po sygnale właściwym jak i PRZED nim. I to zarówno podczas ekstremalnego podbijania jak i ekstremalnego tłumienia! Pozostaje zatem pytanie: jak tego typu filtry mogą pełnić funkcję naprawczą jeśli chodzi o charakterystykę, skoro bardzo głęboko wpływają na to, co się dzieje z energią dźwięku już po stronie źródła?

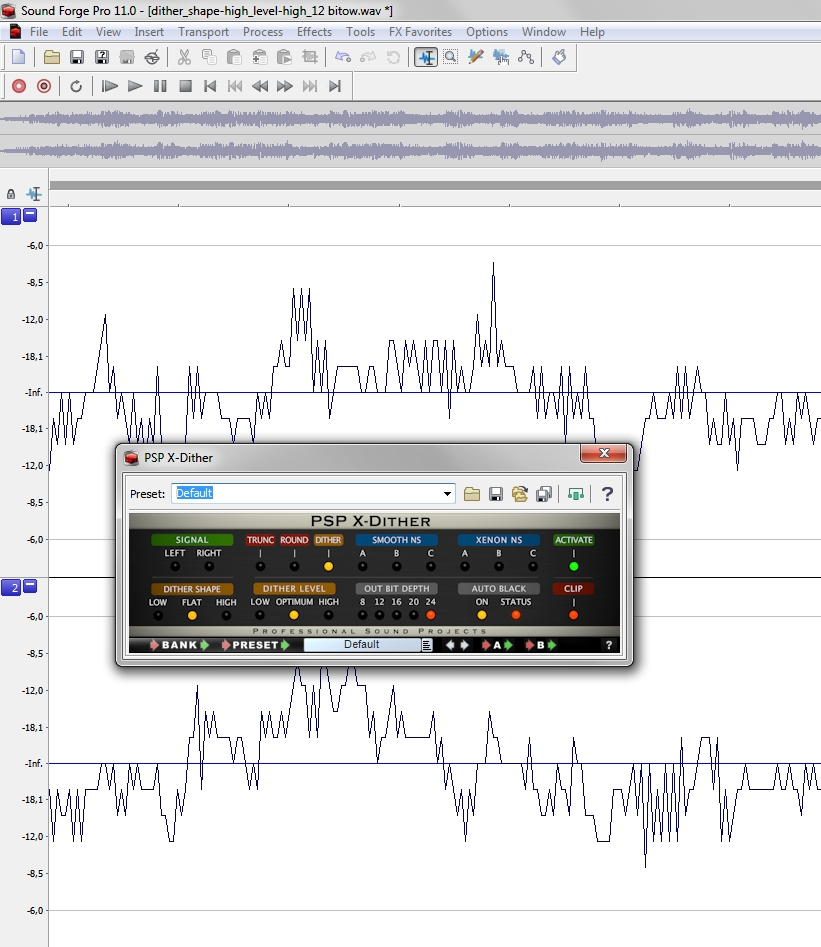

Dithering, czyli (nie taka) czarna magia

O przewagach zapisu i edycji dźwięku z rozdzielczością 24-bitową chyba nikogo nie trzeba przekonywać. Wystarczy powiedzieć, że na 1 bit rozdzielczości przypada 6 dB zakresu dynamiki, więc pliki 16-bitowe mogą mieć teoretyczny zakres dynamiki 96 dB, a pliki 24-bitowe już 144 dB. To oznacza, że rozpiętość dynamiczna między najcichszym sygnałem w materiale muzycznym (jest to zazwyczaj poziom szumów własnych wykorzystywanych urządzeń), a maksymalnym nieprzesterowanym sygnałem jest w przypadku tych drugich aż o 48 dB większa. Dzięki temu możemy rejestrować i przetwarzać dźwięk z niższym poziomem bez obawy o utratę jego dynamiki, mając jednocześnie duży zapas dla odpowiedniej prezentacji transjentów. Praca w 24, a nawet 32 bitach daje też więcej swobody na etapie miksowania, ponieważ dostępny zakres dynamiki znacząco przekracza ten sam parametr występujący nawet w najwyższej klasy sprzęcie audio.

O przewagach zapisu i edycji dźwięku z rozdzielczością 24-bitową chyba nikogo nie trzeba przekonywać. Wystarczy powiedzieć, że na 1 bit rozdzielczości przypada 6 dB zakresu dynamiki, więc pliki 16-bitowe mogą mieć teoretyczny zakres dynamiki 96 dB, a pliki 24-bitowe już 144 dB. To oznacza, że rozpiętość dynamiczna między najcichszym sygnałem w materiale muzycznym (jest to zazwyczaj poziom szumów własnych wykorzystywanych urządzeń), a maksymalnym nieprzesterowanym sygnałem jest w przypadku tych drugich aż o 48 dB większa. Dzięki temu możemy rejestrować i przetwarzać dźwięk z niższym poziomem bez obawy o utratę jego dynamiki, mając jednocześnie duży zapas dla odpowiedniej prezentacji transjentów. Praca w 24, a nawet 32 bitach daje też więcej swobody na etapie miksowania, ponieważ dostępny zakres dynamiki znacząco przekracza ten sam parametr występujący nawet w najwyższej klasy sprzęcie audio.

Cóż z tego, kiedy na sam koniec nasza produkcja muzyczna i tak skończy jako plik w rozdzielczości 16-bitowej – czy to jako ścieżka na płycie CD, czy też jako MP3 dostępne w Internecie.

Aby plik produkcyjny, który ma zazwyczaj 24-bitową rozdzielczość, przekształcić do postaci 16-bitowej, trzeba usunąć w poszczególnych słowach bitowych, z których każde opisuje w systemie dwójkowym wartość poszczególnych próbek sygnału, 8 najmłodszych bitów. Najmłodszych, czyli tych, które odpowiadają za najniższe poziomy. Jeżeli je ot tak po prostu usuniemy za pomocą obcinania bitów (truncate), to w sygnale wynikowym braknie informacji o najcichszych składowych. W przypadku głośnych sygnałów będzie to oznaczało nieznaczną zmianę w ich brzmieniu, ale w przypadku tych cichszych, zwłaszcza wybrzmiewających, będzie już wyraźnie słychać zniekształcenia dźwięku.

Dlatego właśnie wymyślono dithering, czyli roztrząsanie, które może przyjmować różne formy. Najprostszą, choć nie uważaną za właściwy dithering, jest zaokrąglanie wartości poszczególnych sampli, które pozwala w pewnym zakresie złagodzić skutki prostego obcinania bitów. Bardziej zaawansowane formy ditheringu polegają na dodaniu specjalnie ukształtowanego szumu o bardzo niskim i zależnym od materiału dźwiękowego poziomie oraz składzie (niejako wplatając go w sygnał), który sumując się z najcichszymi dźwiękami w materiale 24-bitowym sprawia, że jego elementy składowe zostają niejako przeniesione do tych wartości, które nie będą podlegały redukcji bitów albo przesunięte w widmie sygnału poza zakres słyszalny.

Aby zaprezentować działanie algorytmu ditheringu niemalże jak pod mikroskopem, zmniejszyłem poziom oryginalnego 24-bitowego nagrania o 48 dB, a następnie fragment ten poddałem działaniu procesora PSP X-Dither (test w lutowym numerze magazynu Estrada i Studio) z różnymi ustawieniami, aplikując zmniejszenie rozdzielczości do 12 bitów. Pliki po poddaniu ditheringowi zostały następnie znormalizowane, aby można było lepiej usłyszeć różnice w działaniu algorytmów ditheringu.

Oczywiście w warunkach realnej pracy nikt nie będzie stosował tak skrajnych zabiegów, ale prezentacje te pozwolą lepiej zrozumieć, na czym polega dithering i jakie są efekty jego działania. Zaznaczam raz jeszcze – mamy tu do czynienia z ekstremalną sytuacją i ekstremalnie niekorzystnymi dla brzmienia warunkami. Przy rzeczywistej konwersji bitowej słyszane tu zjawiska odbywają się na poziomie praktycznie niesłyszalnym.

Pogadanka Na Temat. Monitory, cz. 4

Pewno już Was trochę zmęczyło to rozbieranie bass-refleksu na czynniki pierwsze i zapewne oczekujecie jakichś bardziej konkretnych porad i sugestii. Pierwsze pytanie jakie się pojawi zapewne brzmi: „czy lepiej żeby bass-reflex był z przodu czy z tyłu?”. Każdy producent potrafi znaleźć bardzo umiejętne wytłumaczenie zastosowanego rozwiązania i z reguły będzie miał rację. Generalnie: bass-reflex z tyłu wymaga przeprowadzania szeregu różnych prób z ustawieniem monitorów w naszym pomieszczeniu. Z mojego doświadczenia wynika jednak, że jeśli już znajdziemy dobre miejsce i konstrukcja jest wykonana prawidłowo (czytaj: znaleziono optymalny kompromis jeśli chodzi o właściwości głośnika, litraż obudowy, szybkość przetwarzania i właściwości portu bass-reflex), to bas w takim monitorze ma szanse na to, żeby być lepiej kontrolowany niż w monitorach z bass-refleksem z przodu. Dlaczego? Ponieważ bass-reflex z przodu jest trzecim źródłem fal na panelu czołowym monitora dwudrożnego, a czym więcej tych źródeł i czym większa między nimi odległość, tym trudniej uzyskać spójność w bliskim polu odsłuchowym (w dalszym polu nie ma to już większego znaczenia i dlatego monitory średniego pola i główne prawie zawsze mają bass-reflex z przodu). Kolejna korzyść z umieszczenia portu z tyłu to brak słyszalnych turbulencji biorących się z przepływu powietrza przez tunel portu – jeśli są, to nie słychać ich w takim stopniu, w jakim można by je było usłyszeć, gdyby port znajdował się z przodu.

Pewno już Was trochę zmęczyło to rozbieranie bass-refleksu na czynniki pierwsze i zapewne oczekujecie jakichś bardziej konkretnych porad i sugestii. Pierwsze pytanie jakie się pojawi zapewne brzmi: „czy lepiej żeby bass-reflex był z przodu czy z tyłu?”. Każdy producent potrafi znaleźć bardzo umiejętne wytłumaczenie zastosowanego rozwiązania i z reguły będzie miał rację. Generalnie: bass-reflex z tyłu wymaga przeprowadzania szeregu różnych prób z ustawieniem monitorów w naszym pomieszczeniu. Z mojego doświadczenia wynika jednak, że jeśli już znajdziemy dobre miejsce i konstrukcja jest wykonana prawidłowo (czytaj: znaleziono optymalny kompromis jeśli chodzi o właściwości głośnika, litraż obudowy, szybkość przetwarzania i właściwości portu bass-reflex), to bas w takim monitorze ma szanse na to, żeby być lepiej kontrolowany niż w monitorach z bass-refleksem z przodu. Dlaczego? Ponieważ bass-reflex z przodu jest trzecim źródłem fal na panelu czołowym monitora dwudrożnego, a czym więcej tych źródeł i czym większa między nimi odległość, tym trudniej uzyskać spójność w bliskim polu odsłuchowym (w dalszym polu nie ma to już większego znaczenia i dlatego monitory średniego pola i główne prawie zawsze mają bass-reflex z przodu). Kolejna korzyść z umieszczenia portu z tyłu to brak słyszalnych turbulencji biorących się z przepływu powietrza przez tunel portu – jeśli są, to nie słychać ich w takim stopniu, w jakim można by je było usłyszeć, gdyby port znajdował się z przodu.

Małe monitorki i bass-reflex z przodu? Trochę to ryzykowne, ale niektórzy producenci robią na przykład dwa wąskie wyloty po obu stronach przetwornika wysokich tonów (swego czasu tak robił Genelec w swoich małych monitorach, teraz już stosuje to tylko w dużych), komasując wszystkie źródła dźwięku jak najbliżej siebie. Teoretycznie port bass-refleksu z przodu pozwala ustawić monitory bliżej ściany, a nawet w jej bezpośrednim sąsiedztwie. Tu jednak nie jestem już pewny, czy to takie oczywiste. Zbyt często spotykałem się z tym, że nawet monitory z bass-refleksem z przodu dość mocno reagowały na ich odległość od ściany. Fale o niskich częstotliwościach nie mają takich właściwości kierunkowych jak te o wyższych, a zatem każda twarda i niepochłaniająca energii przegroda umieszczona w pobliżu ich źródła ma wpływ na ich zachowanie się.

Małe monitorki i bass-reflex z przodu? Trochę to ryzykowne, ale niektórzy producenci robią na przykład dwa wąskie wyloty po obu stronach przetwornika wysokich tonów (swego czasu tak robił Genelec w swoich małych monitorach, teraz już stosuje to tylko w dużych), komasując wszystkie źródła dźwięku jak najbliżej siebie. Teoretycznie port bass-refleksu z przodu pozwala ustawić monitory bliżej ściany, a nawet w jej bezpośrednim sąsiedztwie. Tu jednak nie jestem już pewny, czy to takie oczywiste. Zbyt często spotykałem się z tym, że nawet monitory z bass-refleksem z przodu dość mocno reagowały na ich odległość od ściany. Fale o niskich częstotliwościach nie mają takich właściwości kierunkowych jak te o wyższych, a zatem każda twarda i niepochłaniająca energii przegroda umieszczona w pobliżu ich źródła ma wpływ na ich zachowanie się.

Podsumujmy ten temat następująco. W bliskim polu odsłuchowym, z jakim mamy do czynienia w typowych domowych studiach, kontrola niskich tonów zawsze będzie bardzo trudna, bez względu na rodzaj i rozmieszczenie portu bass-reflex. Wcale nie jest przypadkiem to, że klasycznymi odsłuchami bliskiego pola stały się Yamaha NS-10M i Auratone 5C, ponieważ obie to konstrukcje zamknięte. Taki monitor trudno jednak dzisiaj sprzedać (mówię o konstrukcji zamkniętej), ponieważ emitowany przez niego bas jest niewystarczający dla współczesnych użytkowników.

Subwoofer? Czemu nie? Jeśli robimy ścieżki efektowe albo muzykę do gier, to jak najbardziej. Jeśli jednak robimy „tradycyjną” muzykę i do tego w małym pomieszczeniu, to bardzo trudno będzie uzyskać optymalną spójność brzmienia w zakresie niskich tonów. Owszem, bas będzie lepiej słyszalny, ale będzie jakby „odklejony” od pozostałych pasm. Można się nauczyć pracować na takim systemie i znam wiele przykładów bardzo udanych połączeń monitorów zamkniętych z subwooferem, ale zawsze jest to trochę loteria, z tym mniejszym prawdopodobieństwem wygrania, im mniejsze jest pomieszczenie, w którym taki odsłuch ma grać.

Subwoofer? Czemu nie? Jeśli robimy ścieżki efektowe albo muzykę do gier, to jak najbardziej. Jeśli jednak robimy „tradycyjną” muzykę i do tego w małym pomieszczeniu, to bardzo trudno będzie uzyskać optymalną spójność brzmienia w zakresie niskich tonów. Owszem, bas będzie lepiej słyszalny, ale będzie jakby „odklejony” od pozostałych pasm. Można się nauczyć pracować na takim systemie i znam wiele przykładów bardzo udanych połączeń monitorów zamkniętych z subwooferem, ale zawsze jest to trochę loteria, z tym mniejszym prawdopodobieństwem wygrania, im mniejsze jest pomieszczenie, w którym taki odsłuch ma grać.

„Panie Wróblewski! To co mam w końcu wybrać? Bo jak na razie, to wszystko ma jakieś wady!”. Bo tak właśnie jest. Każda konstrukcja akustyczna to pewien kompromis, a w grę wchodzą takie zmienne jak kształt, wielkość i adaptacja akustyczna pomieszczenia, rozmieszczenie monitorów i innych elementów umeblowania/aparatury, że o cenie i konstrukcji samych monitorów nawet nie wspomnę. W skrajnych przypadkach, gdy sam mam problem z porównaniem konkretnych modeli, to czekam na jakiś ciepły, słoneczny i bezwietrzny dzień, wystawiam sobie stół na trawę za domem, gdzie do najbliżej przeszkody akustycznej pod postacią ściany mam jakieś 8 metrów i sobie słucham.

Słucham? Że fale odbijają się od ziemi? No jasne, że tak! Ale czy w studiu, w którym te monitory będą pracować, nie ma podłogi? Chodzi się w powietrzu albo po stalowej siatce, jak w komorze bezechowej? Nie da rady, podłoga być musi i choćby dlatego pomiary w komorze bezechowej są bardzo cenne dla konstruktorów i mogą być materiałem dla wiarygodnych porównań, ale w praktyce nie powiedzą całej prawdy o monitorach. Policzmy szybko w pamięci: nawet jeśli zapomnimy o obecności ścian i sufitu, to podłoga jest twardą, niepochłaniającą niskich tonów przegrodą, która w znacznym stopniu odbija ich energię. Przeciętna odległość monitorów od podłogi wynosi ok. 1,5 metra (licząc z grubsza i po skosie). 1,5 metra odpowiada długości fali o częstotliwości ok. 227 Hz (340 dzielimy przez 1,5). Na pewno zatem przy tej częstotliwości nastąpi jakieś zafalowanie na charakterystyce nawet najbardziej wyrównanych pasmowo monitorów. Powiem więcej: pojawi się ono także przy 454 Hz, czyli oktawę wyżej.

Zostawmy jednak na boku te wszystkie wyliczenia. Nie jesteśmy przecież fizykami tylko ludźmi zajmującymi się muzyką. Po prostu posłuchajmy naszych monitorów pamiętając o tym, że każdy ma swoje wady. Ale niech te wady nie przysłonią Wam ich zalet (jeśli w ogóle takie są…). Ciąg dalszy nastąpi.

Tomasz Wróblewski

Pogadanka Na Temat, cz. 1

Pogadanka Na Temat, cz. 2

Pogadanka Na Temat, cz. 3

Pogadanka Na Temat. Monitory, cz. 2

Skonstruowanie taniego i w miarę przydatnego monitora z grupy tzw. budżetowych to trudna sprawa. Paradoksalnie, często dużo trudniejsza niż wykonanie monitora wysokiej klasy. O ile w tym drugim przypadku należy postępować zgodnie z regułami, czyli dobrać odpowiednie przetworniki (zazwyczaj dość kosztowne), zamontować je w starannie obliczonej skrzynce, a następnie metodą wielokrotnych pomiarów, odsłuchów i drobnych zmian zbliżać się do założonego celu, to w przypadku monitorów budżetowych jest inaczej. Tutaj trzeba tanie głośniki obsadzić w jak najtańszej obudowie, dopasować je tak, aby zagrały w miarę przyzwoicie, zrobić dość ciekawy design i sporo zainwestować w reklamę. Do tego jeszcze do minimum trzeba skrócić okres projektowania, pomiarów i testów odsłuchowych, bo po prostu nie ma na to czasu. Za pół roku, a najdalej za rok, musi wyjść kolejny model, bo w przeciwnym razie wypadamy z handlu.Czytaj dalej

Skonstruowanie taniego i w miarę przydatnego monitora z grupy tzw. budżetowych to trudna sprawa. Paradoksalnie, często dużo trudniejsza niż wykonanie monitora wysokiej klasy. O ile w tym drugim przypadku należy postępować zgodnie z regułami, czyli dobrać odpowiednie przetworniki (zazwyczaj dość kosztowne), zamontować je w starannie obliczonej skrzynce, a następnie metodą wielokrotnych pomiarów, odsłuchów i drobnych zmian zbliżać się do założonego celu, to w przypadku monitorów budżetowych jest inaczej. Tutaj trzeba tanie głośniki obsadzić w jak najtańszej obudowie, dopasować je tak, aby zagrały w miarę przyzwoicie, zrobić dość ciekawy design i sporo zainwestować w reklamę. Do tego jeszcze do minimum trzeba skrócić okres projektowania, pomiarów i testów odsłuchowych, bo po prostu nie ma na to czasu. Za pół roku, a najdalej za rok, musi wyjść kolejny model, bo w przeciwnym razie wypadamy z handlu.Czytaj dalej

Pogadanka Na Temat. Monitory, część 1

Przed premierą nowego wydawnictwa 0dB.pl, o którym więcej szczegółów już wkrótce, postanowiłem opublikować cykl pogadanek z nim związanych i sygnalizujących jego tematykę, treść i zawartość. Potraktujcie to jako swego rodzaju wprowadzenie, siłą rzeczy mocno skrócone i w odcinkach. W pierwszych naszych Pogadankach Na Temat zajmiemy się bliżej kwestiom studyjnych monitorów odsłuchowych, a potem poruszymy szereg innych, nie mniej pasjonujących tematów.

Przed premierą nowego wydawnictwa 0dB.pl, o którym więcej szczegółów już wkrótce, postanowiłem opublikować cykl pogadanek z nim związanych i sygnalizujących jego tematykę, treść i zawartość. Potraktujcie to jako swego rodzaju wprowadzenie, siłą rzeczy mocno skrócone i w odcinkach. W pierwszych naszych Pogadankach Na Temat zajmiemy się bliżej kwestiom studyjnych monitorów odsłuchowych, a potem poruszymy szereg innych, nie mniej pasjonujących tematów.

Na rynku odsłuchów do domowego i projektowego studia nagrań dominują monitory bliskiego pola. Jeśli pominąć problemy z przetwarzaniem niskich tonów, wynikające z charakteru samego pomieszczenia, stanowią one całkiem niezłe rozwiązanie w zakresie odsłuchu nawet na poziomie półprofesjonalnym. Biorąc pod uwagę fakt, że przez długie lata zawodowi realizatorzy korzystali z takich monitorów jak Auratone czy Yamaha NS10 (zresztą korzystają z nich do dziś, sam mam na biurku klony Auratonów, czyli Avantone), zdecydowana większość współcześnie produkowanych zestawów monitorowych – które na ogół mają lepsze parametry jakościowe niż wspomniane dwa klasyki – może bez większych problemów być wykorzystana jako dość wiarygodny odsłuch w domowym studiu. Trzeba jednak pamiętać, że monitor monitorowi nierówny i z ceną budżetowych na ogół rozwiązań związane są pewne kompromisy.Czytaj dalej

Produkcja Muzyczna – Edycja 2014

Ci z Was, którzy śledzą nowości związane z magazynem Estrada i Studio, zapewne wiedzą już o nowym wydaniu EiS Plus. Jeśli jednak nie jesteście na bieżąco – niedawno do sprzedaży trafiło najnowsze wydanie magazynu Estrada i Studio Plus, noszące tytuł Produkcja Muzyczna – Edycja 2014.

Ci z Was, którzy śledzą nowości związane z magazynem Estrada i Studio, zapewne wiedzą już o nowym wydaniu EiS Plus. Jeśli jednak nie jesteście na bieżąco – niedawno do sprzedaży trafiło najnowsze wydanie magazynu Estrada i Studio Plus, noszące tytuł Produkcja Muzyczna – Edycja 2014.

Choć sama produkcja muzyczna jest terminem dość ogólnym i odnoszącym się do wielu procesów (mniej lub bardziej twórczych), w poradniku tym, wraz z osobami z redakcji EiS, zajęliśmy się możliwie najbardziej praktycznym i przystępnym opisaniem dosłownie wszystkiego, z czym na co dzień spotykają się ludzie tworzący muzykę. Kiedy podejmiemy próbę rozpisania wszystkiego, co wchodzi w skład produkcji muzycznej, okazuje się, że choć oczywiście można o tym pisać w nieskończoność, to jednak większość etapów pozostaje niezmienna i można je dokładnie opisać krok po kroku.

Największy nacisk został położony na praktyczne zastosowanie zawartej w Poradniku wiedzy. Poruszane są tutaj takie tematy, jak tworzenie melodii (a nie każdemu przychodzi to z łatwością), programowanie rytmów, dobór instrumentów, brzmienia perkusyjne, zastosowanie efektów, miks oraz mastering. Na każdy z tych tematów chcieliśmy rzucić jak najwięcej światła, pokazując przy tym to, co nie zawsze można znaleźć w książkach i internecie.

Tradycyjnie do Poradnika dołączona została płyta DVD. Jej zawartość jest ściśle powiązana z treścią Poradnika – znajdują się na niej presety, przykłady audio, pliki MIDI, materiały źródłowe i wszelkie inne materiały dodatkowe.

Choć Produkcja Muzyczna – Edycja 2014 jest w sprzedaży od niedawna, cała Redakcja EiS, jak również ja sam, otrzymaliśmy bardzo wiele pozytywnych opinii na temat tego Poradnika. Przyznam, że bardzo mnie to cieszy, gdyż, tutaj pozwolę sobie przytoczyć własne słowa – „Mam wszelkie podstawy ku temu, by sądzić, że jest to jedna z najważniejszych publikacji, jakie powstały w dotychczasowej, już 18-letniej historii magazynu Estrada i Studio”.

Więcej informacji o Poradniku znajdziecie na stronie EiS. Magazyn można kupić w salonach Empik w całej Polsce oraz na stronie UlubionyKiosk.pl.

Jeśli interesuje Was tematyka produkcji muzycznej, zachęcam do zapoznania się również z moimi publikacjami w formie kursów na płytach DVD i do pobrania na stronie Sklepu 0dB.pl.

Koszyk (

Koszyk (